21世纪经济报道记者骆轶琪 郑州报道

从2022年末ChatGPT发布至今,AI大模型的模型参数及技术架构持续演进,由此对智能算力的需求也在飙升,相关基础设施产业链都在面临新的变化。

近日举行的“2024智算时代数据中心技术引领与变革论坛”上,中国信通院云大所数据中心部总工程师郭亮在演讲中指出,算力中心发展经历了三个阶段:在2000-2010年间,数据中心由三大通信运营商为主导;2010-2020年间,随着数据中心需要更多专业技术能力加持,开始有第三方数据中心服务商加入;到现在的智算中心时代,数据中心主体开始呈现百花齐放的发展态势,但同时也面临寻找正确的发展路径命题。

这不同于此前以CPU为主导的发展时代,在GPU为主导时代,包括底层芯片、基础设施、网络架构、应用生态等方面发生了较大变化,产业链厂商亟需密切联合,探路新技术路线下的演进方向。

秦淮数据CTO张炳华对21世纪经济报道记者表示,目前国内第三方数据中心服务商主要有两种运营模式:超大规模定制模式和传统通用零售模式。随着AI大模型快速发展,对数据中心的需求走向更大规模AI集群,超大规模定制模式的优势凸显。对此,秦淮数据升级发布“智算中心全栈解决方案2.0”,并联合生态伙伴,共同启动相关行业标准立项。

业内认为,伴随国内智能计算生态的能力演进,并在此过程中推动产业走向标准化,将有望更好抢占AI浪潮下的新发展机遇。

中国信息通信研究院发布的《算力中心冷板式液冷发展研究报告(2024年)》(下称“报告”)显示,截至2023年底,我国在用算力服务机架数已达到810万标准机架,算力总规模达230EFLOPS。大型以上算力中心机架数量占算力中心总机架规模比重逐年上涨,部分超大型算力中心的平均单机柜功率已达20kW。由此可见,高功率密度、高算力的大型、超大型算力中心将是未来建设的重点。

这也意味着面对GPU为核心的智算中心基础设施生态需要快速应变。

郭亮指出,目前智算中心的生态发展以英伟达CUDA生态一枝独秀,在早期以CPU为核心的X86时代,虽然主导厂商数量也少,但芯片和应用、基础设施之间没有过强的耦合关系;到了AI时代,从底层芯片到网络、框架、应用、基础设施,彼此之间耦合度极高,由此导致一家厂商占据了80%~90%的极高份额。因此,行业企业如何找到自己的定位、围绕算力基础设施做更多开创性工作成为重要话题。

从基础设施、网络、计算、运营多个方面带来机会同时也有挑战:如何将网络与计算融合是当前被高度关注的话题;基础设施主要包括电和冷,近期微软、甲骨文相继宣布要重启关闭多年的核电站,就是基于电力紧俏而做出应对,冷即散热方式从风冷转向液冷;运营主要指目前政策层面推进的算力调度平台建设。

技术和生态面临较多转向、需要产业链协同解决问题比较多,其中一个重点就包括散热方式。

张炳华分析,在通用计算发展时期,CPU芯片功耗从2010年到2019近十年仅增长了一倍左右,单机柜功率从几千瓦提升到十千瓦;但在智能计算发展时期,GPU卡的功耗持续翻倍,GPU服务器单机柜功率密度从原来的近十千瓦左右,提升到现在的一百三十多千瓦,提升了十几倍。这让功率密度、消耗电量等方面大幅提高,由此带来新的散热命题。

“在我们看来,数据中心在同样条件下,如何保证芯片、服务器和网络安全稳定运行,根本问题是解决供电、制冷、遭遇故障后冗余等方面问题。”他续称,这就需要从基础设施系统架构、设计方案,到产品化、预制化等方向推进,由此进行标准化落地,也更容易实现规模效益。

前述会议上,秦淮数据推出“磐石”模块数据中心框架,包括高弹性建筑模型、“玄铁”极简供电架构、“玄冰”极致冷却架构和“玄智”智能运维系统,以支持高密及超高密智算场景。

其中,高弹性建筑模型的模块架构可灵活配置、分期预制,同时兼容CPU和GPU不同算力场景;“玄铁”架构将传统配电全链路的10余个环节设备融合成变电站、柴发、中压、低压、电池、IT六大机电模块,可分阶段部署和弹性扩容;“玄冰”架构包括风冷、液冷、风液兼容等模块,以解决8kW-150kW区间所有功率密度的机柜冷却难题。

张炳华对21世纪经济报道记者表示,采取通用方案来建设机房的基础设施,从建筑封顶到正式投入运营期间会有3-6个月的准备期,用来安装供电、冷却等系统。目前采用液冷方案需要更长的建设周期、更长的服务器研发周期,为了尽快上线大模型,获得比竞对更高的算力,客户会优先选择能够更快部署的风冷方案。所以在风冷向液冷方案转换的初期,鉴于风冷散热方案成熟且通用,以及企业对采用新技术路线可能带来的风险存在担忧,大部分客户缺乏积极主动选择液冷方案的动力。

“目前颇受关注的冷板液冷方案也面临如水质、冷却液泄露、微通道拥堵甚至腐蚀等问题,一旦设计方案不合理、建设质量没有保证、运维管理不当等,对业务运行来说会面临更高的故障风险。但风冷散热能力已达极限,无法适应未来高密度机柜的冷却需求,因此,当下阶段液冷小规模的尝试和验证一定要做,这是未来通向大规模使用场景的必经阶段。”他续称。

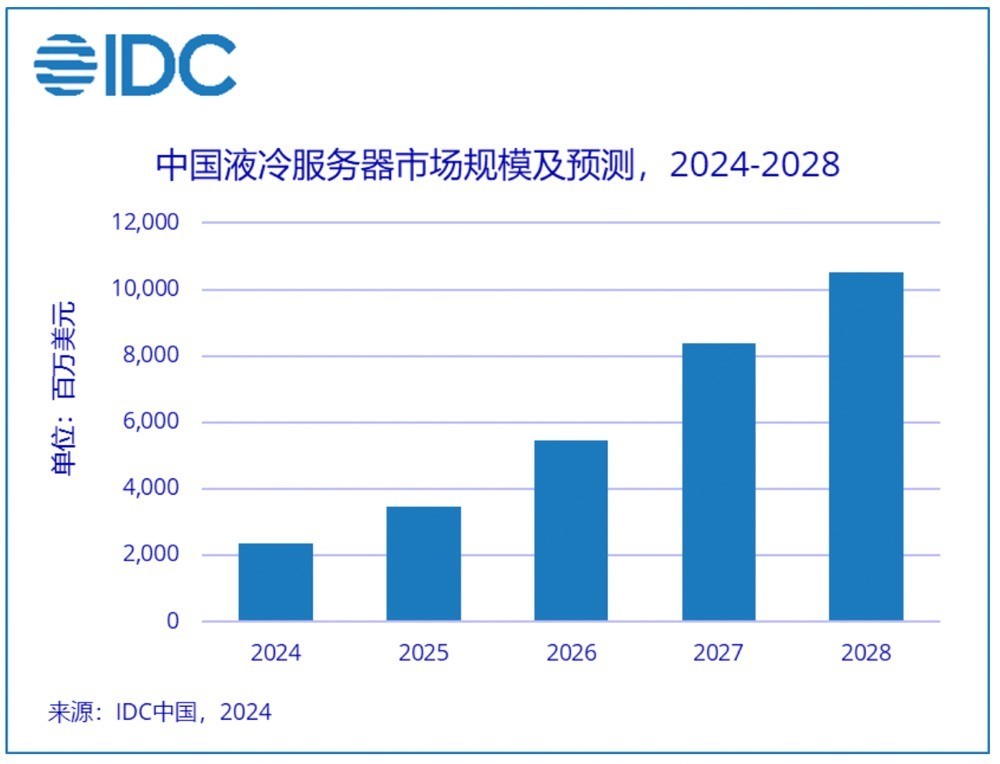

需求驱动下,当前液冷技术已经在快速渗透。调研机构IDC统计显示,中国液冷服务器市场在2024上半年继续保持快速增长,市场规模达12.6亿美元,同比增长98.3%,其中液冷解决方案仍以冷板式为主,占95%以上。根据调研机构IDC的统计和预测,2023-2028年,中国液冷服务器市场年复合增长率将达到47.6%,2028年市场规模将达到102亿美元。

张炳华对21世纪经济报道记者分析,从传统风冷向液冷转换过程中,面临的本质上并不是单一商业逻辑难题,更多源于当前液冷散热生态不够成熟。

例如服务器在液体中运行时,遇到一些液体会产生化学反应,这在过去行业并没有积累足够的应对经验,需要较长时间来对主要液体材料的兼容性和稳定性进行验证。但考虑到GPU成本偏高,且并不对浸没式液冷方案承诺质保,令厂商尝试浸没式液冷时有更多顾虑。

这与新技术在发展早期面临的标准化、兼容性不足有关。但产业界已经在驱动解决这一现状。

前述《报告》分析,当前我国针对液冷技术的研究仍处于起步阶段,液冷服务器的设计、运维、安防等方面的行业标准较为空缺,业内尚未形成统一的技术标准,增高了产业发展壁垒。得益于政策支持与引导,液冷产业标准规范化迎来了快速发展。特别是冷板式液冷技术标准制定逐步朝向常态化、规范化迈进。

目前市场上的液冷方案主要包括三类:冷板式液冷、浸没式液冷、喷淋式液冷。张炳华认为,在多个液冷散热方案中,冷板液冷相对更成熟、对现有服务器生态的改变更少,因此业界目前更侧重于推进冷板液冷方案完善。

“如果要采用浸没式液冷方案,对服务器网络、电源等生态都要有较大改变。在液冷方案发展初期会不太具备规模效益。但冷板液冷方案可以同时适配GPU、CPU等主计算单元的能力和生态。相比之下,从风冷方案改为冷板液冷方案的难度更小。”他进一步指出。

IDC中国服务器市场研究经理辛一认为,从全球范围看,液冷方案目前在海外的应用尚不广泛,只在一些头部CSP(云服务商)的集群节点中有所应用。英伟达最新的Blackwell平台预计在今年末或2025年初在全球范围大量出货,新平台自身功耗较高,自然对液冷方案的应用起到促进作用。

“如果中国在此时机下,不论是服务器产品设计、制造、销售和维护方面,还是液冷数据中心基础设施建设等领域积累丰富经验,必将在整个液冷市场中发挥重要作用。同时,还需要产业相关组织、机构、企业及合作伙伴,在液冷方案实际应用过程中精诚合作,共同制定适合液冷发展的行业或组织标准,加快促进产学研的高效融合。”他续称。

前述论坛上,“冷板液冷系统全生命周期质量控制规范系列行业标准”启动立项,专家组同期成立。该系列标准将由中国信通院和秦淮数据牵头,联合数十家行业头部企业共同编制。

张炳华告诉记者,目前国际上对于液冷散热技术虽然没有形成完整统一的标准,但并不意味着对液冷方案没有技术要求。在这些要求逐渐完善后,才会形成标准定式。

此前对数据中心制定标准主要由互联网厂商牵头,但在智能计算发展需求下,服务器硬盘布局进行了重新设计,改变了既有生态模式。因此,现在需要产业链厂商共同参与完善标准制定,根据各自在产业链中的位置协同开发,对市场发展也更具有引导作用。

“我们在制定标准指导规范时,既借鉴行业的基本原则,也参考了ODCC(开放数据中心委员会)的技术要求等方面考虑。”他续称,秦淮数据希望通过参与ODCC、拉通更多产业链生态等方式,让更多元的行业用户共同参与完善早期标准定义过程。

集邦咨询认为,随着全球政府及监管机构对于ESG(环境、社会和公司治理)意识逐渐提升下,将加速带动散热方案由气冷转液冷形式发展,预期液冷方案渗透率逐年攀升,这将促使电源供应厂商、散热业者及系统整合厂等竞相投入AI液冷市场,形成新的产业竞争与合作态势。

更多内容请下载21财经APP